Descubierto pero No Indexado: Guía para resolver el error en Google Search Console

Estrategias avanzadas y soluciones prácticas para optimizar la indexación de tu sitio web.

Si has accedido a Google Search Console y te has encontrado con el temido mensaje «Discovered – currently not indexed» (Descubierto – actualmente no indexado), no estás solo. Este es uno de los problemas de indexación más comunes que enfrentan webmasters, profesionales de SEO y propietarios de sitios web en la actualidad.

Este error significa que Google conoce la existencia de tus páginas pero ha decidido no rastrearlas ni indexarlas aún. Y aunque pueda parecer un problema técnico menor, puede tener consecuencias significativas en la visibilidad de tu sitio web en los resultados de búsqueda.

En este completo artículo, desglosaré qué significa exactamente este error, por qué ocurre, y lo más importante: cómo solucionarlo de manera efectiva para maximizar la indexación de tu contenido valioso.

¿Qué significa «Descubierto – Actualmente No Indexado»?

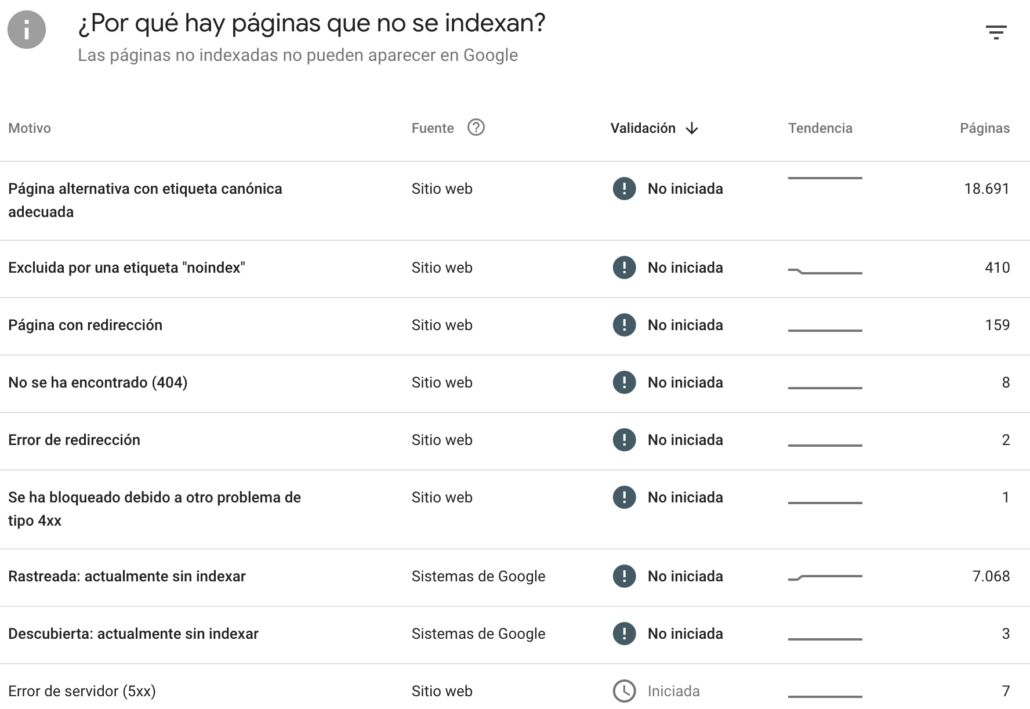

El estado «Discovered – currently not indexed» aparece en el informe de cobertura de índice de Google Search Console, específicamente en la sección de «Páginas» > «Por qué las páginas no están indexadas».

Según la documentación oficial de Google, este estado indica:

«La página fue encontrada por Google, pero aún no ha sido rastreada. Normalmente, Google quería rastrear la URL pero se esperaba que esto sobrecargara el sitio; por lo tanto, Google reprogramó el rastreo. Esta es la razón por la que la última fecha de rastreo está vacía en el informe.»

En términos más simples: Google ha detectado tu página (probablemente a través de tu sitemap XML, enlaces internos o backlinks), pero ha decidido posponer su rastreo e indexación.

Diferencia con otros estados de indexación

Es importante distinguir este error de otros estados similares:

Estado Significado Discovered – not indexed Google conoce la URL pero no la ha rastreado aún Crawled – not indexed Google rastreó la página pero decidió no indexarla (problema de calidad) Excluded by noindex Página excluida intencionalmente mediante etiqueta noindex

¿Por qué ocurre este problema de urls descubiertas, no indexadas?

Según John Mueller de Google, existen dos razones principales por las que una página puede quedar en el estado de «descubierto pero no indexado»:

Limitaciones del presupuesto de rastreo (Crawl Budget)

El crawl budget es el número de páginas que Googlebot está dispuesto a rastrear en tu sitio web dentro de un período determinado. Este presupuesto se determina por dos factores:

- Capacidad de rastreo (Crawl Capacity): Qué tan bien puede tu servidor manejar las solicitudes de Googlebot sin sobrecargarse. Si tu servidor es lento o inestable, Google reducirá su velocidad de rastreo.

- Demanda de rastreo (Crawl Demand): Cuánto quiere Google rastrear tu sitio, basándose en la popularidad de tus páginas, la frecuencia de actualización y la calidad general del contenido.

Problemas de calidad del contenido

Aquí está la cuestión clave: aunque Google no ha rastreado la página específica, puede hacer suposiciones sobre su calidad basándose en otras páginas de tu sitio.

Esto significa que si tu sitio tiene muchas páginas de baja calidad, duplicadas o con contenido superficial, Google puede deprioritizar el rastreo de páginas nuevas, asumiendo que seguirán el mismo patrón.

Factores de calidad que Google evalúa:

- Contenido duplicado o muy similar entre páginas

- Páginas con contenido escaso o de bajo valor (thin content)

- Páginas generadas automáticamente o scraped

- URLs con parámetros excesivos (filtros, ordenamientos)

- Arquitectura del sitio confusa o profundidad de rastreo excesiva

- Falta de enlaces internos o externos de calidad

Por ejemplo, si su web tiene una función de búsqueda interna con parámetros de consulta como /?q=google, o en tu tienda online, tienes filtros de facetas que generen URL como /?color=red&size=s Google rastreará estas urls.

Básicamente, todas esas URL no tienen contenido único y solo filtran los datos que tienes, lo cual es excelente para la experiencia del usuario, pero no para Googlebot.

Permitir que Google rastree estas URL desperdicia presupuesto de rastreo y afecta la rastreabilidad general de tu sitio web. Al bloquearlas mediante reglas de robots.txt , Google centrará sus esfuerzos de rastreo en las páginas más útiles de tu sitio.

Así puedes bloquear la búsqueda interna, las facetas o cualquier URL que contenga cadenas de consulta a través de robots.txt:

Disallow: *?*s=*

Disallow: *?*color=*

Disallow: *?*size=*¿Cuándo deberías preocuparte por este problema?

No todos los casos de «Discovered – currently not indexed» son problemáticos. Es normal que la mayoría de los sitios web tengan algunas páginas en este estado.

Situaciones normales

NO deberías preocuparte si:

- Son páginas nuevas publicadas recientemente (menos de 2-4 semanas)

- Representan menos del 10% de tus páginas importantes

- Son páginas de bajo valor que no necesitan estar en el índice

- Tu sitio tiene menos de 10,000 páginas en total

Situaciones problemáticas

SÍ deberías actuar si:

- Páginas importantes de tu sitio están en este estado durante más de 30 días

- El número de páginas afectadas está creciendo constantemente

- Tus páginas de categoría o producto principales no están indexadas

- Contenido nuevo y de alta calidad no se indexa en semanas

- Notas una caída en el tráfico orgánico correlacionada con este problema

Cómo diagnosticar el problema en tu web

Antes de implementar soluciones, es crucial diagnosticar correctamente la causa raíz del problema.

Verificar si la página está realmente indexada

Paso 1: Verifica la fecha de actualización del informe en Google Search Console (esquina superior derecha).

Paso 2: Realiza una búsqueda manual en Google:

site:tudominio.com inurl:slug-de-la-pagina

Si la página aparece en los resultados, entonces está indexada y el informe simplemente está desactualizado. Dale tiempo para que se actualice.

Analizar el presupuesto de rastreo

Accede a: Configuración > Estadísticas de rastreo en Google Search Console.

Analiza:

- Total de solicitudes de rastreo por día

- Tiempo de respuesta promedio del servidor

- Cantidad de kilobytes descargados

- Códigos de respuesta HTTP (errores 5xx indican problemas de servidor)

Identificar páginas duplicadas o de baja calidad

Un contenido bien escrito es fundamental para tener éxito en Google. Si tu contenido es escaso y no alcanza al menos los niveles de la competencia, podrías tener dificultades incluso para entrar en el top 50.

En nuestra experiencia, el contenido de menos de 1000 palabras no funciona tan bien como el contenido de más de 1000 palabras.

¿Somos una empresa de redacción de contenido? No. ¿El número de palabras es un factor de posicionamiento? Tampoco .

Pero, cuando estás juzgando qué hacer en el contexto de la competencia, asegurarte de que tu contenido esté bien escrito es clave para el éxito.

Utiliza herramientas como:

- Screaming Frog SEO Spider: Para rastrear tu sitio e identificar duplicados, páginas con contenido escaso, URLs con parámetros

- Sitebulb: Análisis visual de arquitectura del sitio y profundidad de rastreo

- Ahrefs Site Audit: Detección de contenido duplicado y problemas de enlazado interno

- Siteliner: Herramienta gratuita para encontrar contenido duplicado

Soluciones prácticas y estrategias de optimización

Ahora que has diagnosticado el problema, es hora de implementar soluciones efectivas.

1º Solicitar indexación manualmente

Esta es la solución más rápida para páginas individuales:

- Abre la herramienta de Inspección de URL en Google Search Console

- Pega la URL completa de la página que quieres indexar

- Haz clic en «Solicitar indexación»

- Espera confirmación (puede tardar de minutos a días)

IMPORTANTE: No solicites indexación repetidamente. Hacerlo una vez es suficiente. Google no rastreará más rápido por solicitudes múltiples.

2º Optimizar el sitemap XML

Tu sitemap XML es una señal importante para Google sobre qué páginas son prioritarias.

Mejores prácticas:

- Incluye solo URLs canónicas: No incluyas páginas duplicadas, con parámetros o versiones alternativas

- Límite de 50,000 URLs por sitemap: Si tienes más, usa un índice de sitemaps

- Actualización automática: Usa plugins como Yoast SEO, Rank Math o SEOPress en WordPress

- Priorización mediante lastmod: Incluye la etiqueta <lastmod> con fechas precisas de actualización

- Envía el sitemap a Search Console: En Sitemaps > Añadir un nuevo sitemap

3º Fortalecer el enlazado interno

Los enlaces internos son fundamentales para distribuir autoridad y señalar importancia a Google.

Estrategias efectivas:

- Añade enlaces desde páginas de alta autoridad: Enlaces desde tu página principal, páginas de categoría o artículos populares

- Incluye en el menú de navegación: Para páginas muy importantes

- Enlaces contextuales: Desde contenido relacionado con anchor text descriptivo

- Sitemaps HTML: Crea páginas de índice organizadas por categorías

- Evita páginas huérfanas: Asegúrate de que todas las páginas importantes tengan al menos 2-3 enlaces internos

Ver Enlaces Internos en SEO: de la transmisión de Autoridad a los Mapas de Entidades

4º Conseguir backlinks de calidad

Los enlaces externos señalan autoridad y relevancia a Google, aumentando la probabilidad de rastreo e indexación.

Tácticas recomendadas:

- Guest posting en sitios relevantes de tu industria

- Menciones en medios y blogs especializados

- Colaboraciones con influencers o expertos

- Compartir en redes sociales profesionales (LinkedIn, Twitter)

- Participación en comunidades y foros especializados

5º Mejorar la calidad del contenido

Como mencionó John Mueller, Google evalúa la calidad global de tu sitio, no solo de páginas individuales.

Acciones de mejora:

- Elimina o mejora contenido de bajo valor: Páginas con menos de 300 palabras, contenido duplicado, o información obsoleta

- Consolida páginas similares: Combina múltiples páginas sobre el mismo tema en una guía completa

- Añade valor único: Datos originales, estudios de caso, ejemplos prácticos, infografías

- Optimiza para E-E-A-T: Experiencia, Expertise, Autoridad y Confianza

- Mejora la estructura del contenido: Usa encabezados H2-H6, listas, tablas, imágenes optimizadas

- Actualiza contenido regularmente: Refresh periódico con información actualizada

Ver Cómo saber si tu contenido realmente ayuda a las personas (y no solo a Google)

6º Optimizar el presupuesto de rastreo

Para sitios grandes (más de 10,000 páginas), optimizar el crawl budget es crítico.

Técnicas avanzadas:

- Bloquea URLs innecesarias en robots.txt: Páginas de búsqueda interna, parámetros de filtrado, páginas de login/registro

- Elimina cadenas de redirecciones: Cada redirección consume presupuesto de rastreo

- Corrige errores 404 y soft 404: Enlaces rotos hacen que Google desperdicie tiempo

- Mejora el rendimiento del servidor: Usa CDN, optimiza base de datos, habilita caché

- Gestiona parámetros de URL: Usa canonicalización en Search Console

- Reduce la profundidad de rastreo: Las páginas importantes deberían estar a máximo 3 clics de la home

7º Actualiza el contenido periódicamente

Los motores de búsqueda rastrearán tu web con mayor regularidad si añades contenido nuevo periódicamente.

Crear contenido de forma regular indica a los motores de búsqueda que tu web está mejorando constantemente y publicando contenido nuevo y, por lo tanto, necesita ser rastreada con más frecuencia para llegar a su público objetivo.

Ver 7 Consejos para actualizar tus contenidos

Errores comunes que debes evitar si quieres mejorar la indexación de tu web

Solicitar indexación repetidamente

Presionar «Solicitar indexación» múltiples veces NO acelera el proceso. De hecho, puede verse como spam y tener el efecto contrario.

Usar noindex en lugar de robots.txt

Si quieres evitar que Google gaste presupuesto de rastreo en ciertas páginas, usa robots.txt para bloquearlas completamente. La etiqueta noindex requiere que Google rastree la página primero.

Ignorar la calidad global del sitio

Enfocarse solo en las páginas específicas con el error sin abordar problemas sistémicos de calidad, duplicación o arquitectura del sitio.

Ver Cómo aparecer en Google y las respuestas de IA en 2026. Mejora tu EEAT, por si acaso.

No monitorear el progreso

Después de implementar cambios, es crucial monitorear el informe de cobertura semanalmente para verificar si las páginas están siendo indexadas.

Herramientas recomendadas para mejorar el SEO de tu web

| Herramienta | Uso principal | Características clave |

|---|---|---|

| Google Search Console | Diagnóstico y monitoreo | Informe de cobertura, estadísticas de rastreo, inspección de URL |

| Screaming Frog | Auditoría técnica | Rastreo completo, detección de duplicados, análisis de enlaces internos |

| Ahrefs | Backlinks y contenido | Site Audit, análisis de backlinks, exploración de contenido |

| Sitebulb | Visualización | Mapas visuales de arquitectura, informes detallados con priorización |

| SEMrush | Análisis competitivo | Site Audit, monitoreo de posiciones, análisis de keywords |

Tendencias de indexación de contenidos en Google

El panorama de indexación continúa evolucionando. Aquí algunas tendencias a tener en cuenta:

IA y rastreo predictivo

Google está implementando algoritmos de inteligencia artificial que predicen qué páginas deben rastrearse con mayor prioridad basándose en intención de usuario, patrones de actualización y señales de calidad más sofisticadas.

IndexNow y notificaciones instantáneas

El protocolo IndexNow, adoptado por Bing y Yandex, permite notificar a los motores de búsqueda instantáneamente sobre cambios en el contenido. Aunque Google aún no lo ha adoptado oficialmente, está en discusión.

Mayor énfasis en experiencia de usuario

Core Web Vitals, usabilidad móvil y experiencia de página seguirán siendo factores cruciales que afectan tanto el rastreo como el ranking.

Contenido generado por IA

Google está refinando su capacidad para distinguir contenido de calidad generado por IA versus spam automatizado. La autenticidad, originalidad y valor seguirán siendo primordiales.

Como ves, el error «Discovered – currently not indexed» puede parecer frustrante, pero es una señal valiosa que te permite identificar y corregir problemas sistémicos en tu sitio web.

- No es siempre un problema: Páginas nuevas o de bajo valor pueden permanecer en este estado temporalmente

- Dos causas principales: Limitaciones de crawl budget y problemas de calidad global del sitio

- Soluciones múltiples: No existe una solución única; requiere un enfoque holístico

- La calidad importa: Google evalúa tu sitio completo, no solo páginas individuales

- Monitoreo continuo: La indexación es un proceso dinámico que requiere supervisión constante

Qué puedes hacer para reducir el número de páginas descubiertas no indexadas

Si te enfrentas a este problema, sigue este plan paso a paso:

Semana 1: Diagnóstico

- Verifica si las páginas están realmente indexadas (búsqueda site:)

- Revisa el informe de cobertura en Search Console

- Analiza estadísticas de rastreo y rendimiento del servidor

- Identifica páginas duplicadas, thin content y problemas técnicos

Semana 2-3: Implementación rápida

- Solicita indexación manual de 5-10 páginas prioritarias

- Optimiza y envía sitemap XML actualizado

- Añade enlaces internos desde páginas de alta autoridad

- Corrige errores críticos (404, redirecciones, velocidad del servidor)

Mes 1-2: Optimización profunda

- Consolida o elimina contenido duplicado y de baja calidad

- Mejora la profundidad y calidad de contenido importante

- Optimiza el presupuesto de rastreo (robots.txt, canonicalización)

- Implementa estrategia de link building para páginas clave

- Mejora arquitectura del sitio y enlazado interno

Mes 2-3: Monitoreo y refinamiento

- Monitorea el informe de cobertura semanalmente

- Rastrea cambios en tráfico orgánico y posiciones

- Ajusta estrategia basándote en datos

- Continúa mejorando calidad y obteniendo backlinks

La indexación en Google es un proceso continuo. El error «Discovered – currently not indexed» es simplemente una oportunidad para optimizar tu sitio web y crear una base sólida para el crecimiento orgánico a largo plazo.

Recuerda que el SEO es una disciplina de paciencia y perseverancia. Los resultados pueden tardar semanas o incluso meses en manifestarse, pero con un enfoque sistemático y basado en datos, eventualmente verás tus páginas importantes indexadas y posicionándose para las consultas relevantes.

Ver Técnicas para optimizar los enlaces internos en SEO

En SEO In House, estamos comprometidos con proporcionarte las estrategias de optimización SEO más actualizadas y efectivas para maximizar la visibilidad de tu sitio web.

Si necesitas ayuda profesional para resolver problemas de indexación o implementar una estrategia SEO integral, no dudes en contactarnos en el 653 030 694, como agencia SEO en Barcelona, llevamos más de 13 años optimizando páginas web y tiendas online para mejorar su posicionamiento en las búsquedas de Google y otros buscadores de IA.

También puedes leer:

Crawling. Qué es y cómo afecta al SEO en 2026

10 conceptos de Marketing Digital que yo optimizaría en 2026

SEO JavaScript. Qué es y cómo afecta al posicionamiento de una web

SEO para IA: Optimización para Inteligencia Artificial Generativa(AIO). Guía completa